Artículos

Impacto y límites de la inteligencia artificial en la práctica jurídica *

Impact and Limits of Artificial Intelligence in the Legal Practice

Impacto y límites de la inteligencia artificial en la práctica jurídica *

Via Inveniendi Et Iudicandi, vol. 17, no. 2, 11, 2022

Universidad Santo Tomás

Received: 04 April 2022

Accepted: 20 May 2022

Resumen: Este artículo de carácter jurídico y de investigación, el cual se aborda desde un enfoque cualitativo con revisión bibliográfica, tiene como objetivo primordial estudiar el impacto de la inteligencia artificial en el campo del derecho, analizándolo desde dos perspectivas específicas; en primer lugar, se estudia el uso de la inteligencia artificial en la práctica jurídica, centrándose en el legal analytics y la heurística del derecho; en segundo lugar, se revisa el problema de la garantía de los derechos y principios jurídicos esenciales frente al uso de las herramientas de inteligencia artificial; todo lo anterior, con el fin de establecer su trascendencia dentro de una correcta práctica y administración de justicia.

Palabras clave: Derecho, heurística jurídica, inteligencia artificial, legal analytics, legaltech, sistemas expertos jurídicos.

Abstract: This article, developed from a perspective of qualitative research based on bibliographical review, finds its primary objective in the study of the impact of artificial intelligence in the field of law, analyzing it from two specific perspectives: firstly, the use of artificial intelligence in the legal practice is studied, focusing on legal analytics and legal heuristics; secondly, the paper addresses the guarantee of legal rights and principles vis-a-vis the use of artificial intelligence tools, in order to establish its relevance within a correct practice and administration of justice.

Keywords: Law, artificial intelligence, legal expert systems, legal heuristics, legal analytics, legaltech.

Introducción

En las enseñanzas de la filosofía y teoría del derecho se insiste, usualmente, con que la configuración moderna de la juridicidad se ha caracterizado por ser la expresión de un paradigma artificialista, lo que sugiere dos cosas: primero, que la estructuración del ordenamiento jurídico y la producción de normas jurídicas son, fundamentalmente, el resultado de la libre elección del legislador (derecho positivo) y, segundo, que el saber jurídico (la ciencia jurídica) se desarrolla básicamente como estudio de esas normas. Estos dos argumentos coinciden con las tesis de una forma de iuspositivismo ( Hayek, 1973, p. 8). Basado en lo anterior, se puede asimilar la construcción de los sistemas jurídicos modernos a la programación y realización de sistemas de inteligencia artificial ante litteram. Quizás ello explique por qué muchos mecanismos típicos del derecho, como el proceso judicial o el razonamiento jurídico, entre otros, han sido tan susceptibles en la época de la revolución digital a incorporar los desarrollos de la inteligencia artificial, lo que ha impactado tanto la teoría como la práctica del derecho ( Acosta y Gual, 2021; Vargas, 2018; Zabala y Zuluaga, 2021).

Lo anterior, no solamente por el apoyo que las nuevas tecnologías brindan a los operadores jurídicos, sino también por la reinterpretación profunda de los temas clásicos a la luz de nuevos conceptos, hasta llegar a abordar temas controversiales, como, por ejemplo, el del juez algoritmo ( Aguirre-Espinosa, 2020). Esto no debe extrañar si pensamos que en sus raíces profundas las tecnologías de la información y el derecho tienen en común un aspecto fundamental: el expresarse o comunicarse a través de un lenguaje normativo, sea en términos de lógica deóntica (el derecho) o en términos de lógica algorítmica (el lenguaje de la informática) ( Galvis y Salazar, 2018; Pertuz y Ropain, 2021).

Como consecuencia de lo expresado, las relaciones entre inteligencia artificial y juridicidad plantean grandes y variados cuestionamientos, los cuales se pueden resumir en dos macrogrupos. En primer lugar, el problema del uso de las herramientas de inteligencia artificial en la práctica jurídica: “la inteligencia artificial en la práctica del derecho”; y, en segundo lugar, el tema de la garantía de unos principios jurídicos básicos —y particularmente de los derechos fundamentales y humanos— en el marco del desarrollo y de la utilización de los sistemas de inteligencia artificial: “el derecho en la práctica de la inteligencia artificial”. Dicho de otra manera, hoy en día las relaciones entre derecho e inteligencia artificial se desarrollan en una doble vía o tensión, dado que, por una parte, existe la necesidad para la juridicidad de adaptarse a los cambios de la realidad científica, social y global, pero a la vez existe la necesidad de que el derecho y su práctica no desconozcan los valores, principios y garantías alcanzadas.

Este escrito abordará estos dos aspectos, intentando desarrollar algunas líneas particulares de las múltiples que se desprenden de los temas mencionados. En este sentido y teniendo presente que “el siglo XXI se ha caracterizado por la digitalización y el uso de las tecnologías de la información y las comunicaciones en diversos escenarios de la vida socioeconómica, laboral, cultural, política e incluso recreativa del ser humano” (Galvis y Pesca, 2020, p. 51), se ahondará en la materia por medio de un análisis de sus antecedentes; luego, se estudiará el uso de la inteligencia artificial en la práctica jurídica, centrándose en su empleo en el contexto del análisis y de la heurística jurídica; posteriormente, se abordará el problema de la garantía de los principios jurídicos como límite en el marco del recurso a la inteligencia artificial, para lo que se escoge concentrar el análisis en el corpus normativo que ha desarrollado al respecto el Consejo de Europa; finalmente, se dará un cierre al texto con unas consideraciones conclusivas.

Antecedentes

Algunos sostienen que los antecedentes de la inteligencia artificial (IA) se deben buscar en los albores de los tiempos, en el periodo helenístico, época en la que existió un inventor, ingeniero y matemático, llamado Herón de Alejandría, quien en su tratado “Los autómatas”, por primera vez en la historia, hizo alusión a la robótica. Mucho después, en la modernidad, con el desarrollo de la ciencia pura y aplicada, por el año 1956, el término inteligencia artificial fue mencionado en la conferencia de Dartmouth en los Estados Unidos, especialmente por los científicos John McCarthy y Marvin Minsky, quienes pretendían buscar la forma de fabricar máquinas inteligentes, con la capacidad de comprender y aprender un lenguaje, pero, sobre todo, de resolver problemas y mejorar por sí mismas.

McCarthy y Minsky plantearon la posibilidad de que el pensamiento pudiera darse fuera del cerebro, es decir, en máquinas; adicional a esto, supusieron que el pensamiento podía ser comprendido de manera formal y científica y que la mejor manera de entenderlo era a través de computadoras digitales ( Cairo, 2011, p. 7).

Desde aquel momento, la inteligencia artificial ha avanzado a pasos agigantados, afectando muchas de las áreas de la vida humana, como los sistemas expertos Dendral, Mycin y Caduceus, los cuales se desarrollaron en los 60, 70 y 80 para la inferencia de estructuras moleculares, diagnosticar enfermedades infecciosas de la sangre y diagnósticos en medicina interna respectivamente. En 1986, el ingeniero alemán Ernst Dickmanns construyó el primer vehículo autónomo, en 1996 la máquina Deep Blue marcó un hito en la historia de la humanidad al derrotar a un campeón mundial de ajedrez. Justo en el momento en el que se redacta este texto, se anuncia, por parte de las empresas Be robot 5 (Br5) y Mimcook, la creación del primer brazo robótico capaz de cocinar de manera autónoma una paella.

En el campo del derecho, prima facie, podría mencionarse que el sistema ha impactado positivamente en la prestación de servicios jurídicos y en la experiencia del usuario dentro del mundo de las tecnologías disruptivas. Ejemplo de esto es el denominado legaltech, así como el legal design o el marketplaces, los smartcontracts, los chatbots y el E-discovery.

En la actualidad, la IA abarca una gran variedad de subcampos, que van desde áreas de propósito general, como el aprendizaje y la percepción, a otras más específicas como el ajedrez, la demostración de teoremas matemáticos, la escritura de poesía y el diagnóstico de enfermedades. La IA sintetiza y automatiza tareas intelectuales y es, por lo tanto, potencialmente relevante para cualquier ámbito de la actividad intelectual humana. En este sentido, es un campo genuinamente universal ( Russell y Norvig, 2004, p. 29).

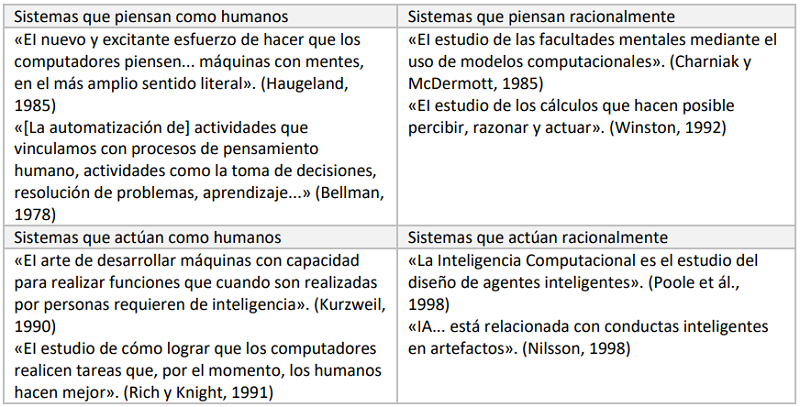

Por otro lado, a lo largo de la historia ha existido un enfrentamiento entre los enfoques centrados en los humanos y los centrados en la racionalidad. El enfoque centrado en el comportamiento humano prioriza a la ciencia empírica, hipótesis y confirmaciones mediante experimentos. El enfoque racional implica una combinación de matemáticas e ingeniería ( Russell y Norvig, 2004, p. 30). La siguiente gráfica es tomada de la fuente mencionada:

Fuente: Russell y Norvig, 2004, p. 30

En síntesis, la inteligencia artificial se define como la disciplina que se ocupa de crear programas informáticos que ejecutan operaciones comparables a las que realiza la mente humana, como el aprendizaje o el razonamiento lógico ( Ho, 2020, p. 489). A su vez, describe la posibilidad de que las máquinas, en alguna medida, piensen o, más bien, imiten el pensamiento humano, a base de aprender y utilizar las generalizaciones que las personas usan para tomar decisiones habituales ( Nieva, 2018, p. 20). La Comisión Europea sostuvo que se trata de sistemas que muestran un comportamiento inteligente al analizar su entorno y tomar acciones con cierto grado de autonomía, con el fin de lograr objetivos específicos ( Comisión Europea, 2018, p. 2).

Es importante aclarar que no todo lo que parezca una máquina o un computador se puede entender como inteligencia artificial, solo aquellos algoritmos que operen bajo el aprendizaje, el razonamiento, la imitación de la inteligencia humana y la toma de decisiones automatizadas, podrían estar dentro del marco de la inteligencia artificial. Esto quiere decir que se debe hablar de inteligencia artificial en la medida en que estemos frente a esquemas de aprendizaje automatizado, esto es, “los programas que le dan a un computador la habilidad de aprender de los datos”. ( Tierney y Kelleher, 2018, p. 13)

El uso de la inteligencia artificial como herramienta en la práctica legal

El derecho debe estar acorde a los cambios sociales, científicos y tecnológicos, en tal sentido, la IA, como ya se insinuó, también ha venido penetrando de manera paulatina el mundo jurídico, en algunos casos, de manera tímida, como es el uso de los procesadores de textos, de buscadores de jurisprudencia o de variables estadísticas para la medición de la eficacia de los juzgados; en otros casos, de manera más acorde a lo que hoy se entiende por inteligencia artificial, como es el caso del algoritmo creado en las universidades de Sheffield y Pensilvania, que sirvió para predecir con un 79 % de acierto el fallo del Tribunal Europeo de Derechos Humanos que se emitió en el 2016. Otro uso que se la ha dado a la inteligencia artificial en el contexto jurídico está relacionado con la reincidencia en materia criminal de las decisiones para la imposición de medidas cautelares en Estados Unidos. De igual forma, en China se creó un robot denominado Xiao Fa, quien estaba programado para dar un asesoramiento legal a los ciudadanos chinos en el tribunal de Beijing; también establecieron en el 2017 los tribunales virtuales o cibernéticos, los cuales son competentes para asuntos relativos a la propiedad intelectual, al comercio electrónico y operaciones en red. En países de Latinoamérica como México, se encuentra Expertius, el cual es un sistema experto de apoyo a la toma de decisiones judiciales en los juicios de alimentos ( Martínez, 2012, p. 841).

Colombia no ha sido la excepción, la Delegatura para los Procedimientos Mercantiles de la Superintendencia de Sociedades y la Fiscalía General de la Nación fueron pioneras en el uso de algoritmos para el ejercicio de sus funciones. En el caso de la Superintendencia de Sociedades, a finales de 2018, se implementó un algoritmo tipo chatterbot que denominó Siarelis (sistema con bases de inteligencia artificial para la Resolución de Litigios Societarios). Por su parte, en mayo de 2019, la Fiscalía General de la Nación empezó a pilotear una herramienta denominada PRISMA (perfil de riesgo para la solicitud de medidas de aseguramiento). Su objetivo es predecir el riesgo de reincidencia de un sujeto procesal respecto de la cual un fiscal debe decidir si solicitar ante los jueces una medida de aseguramiento privativa de la libertad ( Gutiérrez, 2020, p. 507). Igualmente, se encuentran sistemas de inteligencia artificial como el antiguo Prometea, hoy PRETORIA, que se encarga de optimizar el proceso de selección, análisis y estructuración de las sentencias de tutela para revisión de la Corte Constitucional. Finalmente, puede señalarse que existen herramientas como Watson en la Fiscalía, Océano en la Contraloría General de la República y Sofía en la Dirección de Impuestos y Aduanas Nacionales.

Los sistemas expertos jurídicos

Cada uno de los ejemplos anteriores tienen en común que son sistemas que ayudan a la toma de decisiones judiciales, por tal razón, se enmarcan dentro de los sistemas expertos jurídicos (SEJ) o, como también son llamados, sistemas jurídicos basados en el conocimiento.

Es importante aclarar que los sistemas expertos jurídicos ayudan a resolver problemas muy específicos. Existen distintas clases de problemas, los convergentes tipo uno, que se caracterizan por que se sabe desde el principio cuál es el criterio de solución, como, por ejemplo, el armar un rompecabezas. Los problemas convergentes tipo dos, en los que la solución del problema no está determinada, pero es determinable, como es el caso de las demostraciones lógicas y las demostraciones matemáticas; finalmente, existe otro tipo de problemas, los divergentes, que son aquellos en los que para un solo problema existen múltiples soluciones, por los que la solución es determinable en forma decisional, un ejemplo, son las controversias judiciales. De lo anterior se sigue que el SEJ es un sistema computacional que puede plantear posibles soluciones a determinados asuntos jurídicos, aplicando el conocimiento experto en la materia, así como explicar sus razonamientos, pero no es aplicable a todos los problemas jurídicos. Es por ello que, en general, se han usado estas aplicaciones como herramientas de apoyo para los operadores jurídicos en contextos tales como la asesoría o asistencia legal o la función jurisdiccional. ( Martínez, 2012, p. 833)

Un SEJ, al igual que todo sistema experto, está constituido por: a) La base de conocimiento, que contiene una representación simbólica de ciertos objetos y hechos, constituye el acervo de conocimientos especializados necesarios para el desempeño de una tarea y determina el campo de actividad, así como los problemas que pueden ser resueltos por el sistema, es decir, su dominio operativo; b) el motor de inferencia, que es un dispositivo que despliega los patrones o secuencias de razonamiento y búsqueda a lo largo de la base de conocimientos, lo cual posibilita que el sistema encuentre soluciones a los problemas planteados; y c) la interfase con el usuario, que es la parte que permite que el usuario entre en contacto con el sistema y obtenga la asesoría que busca. Generalmente dicho contacto se lleva a cabo en forma de interrogatorio, por el cual, la máquina obtiene información relevante del problema específico por parte del usuario ( Martínez, 2012, p. 834).

El legal analytics

Se ha usado la expresión de analítica jurídica, para referirse al tema del uso de las herramientas de la inteligencia artificial en la práctica jurídica, entendida como un conjunto de técnicas lingüísticas, estadísticas y de aprendizaje automático que modelan y estructuran el contenido de información de fuentes textuales para inteligencia empresarial, análisis de datos exploratorios o investigación. Señala, tajantemente, que, si bien los investigadores de los temas de inteligencia artificial y derecho han logrado grandes avances, se ha producido un cuello de botella en la representación del conocimiento que ha impedido progresar hacia la contribución a la práctica legal; es por ello que hasta ahora, el conocimiento jurídico sustantivo empleado por modelos computacionales, ha tenido que ser extraído manualmente de fuentes legales, es decir, de los casos, estatutos, reglamentos, contratos y otros textos que realmente utilizan los profesionales del derecho. Como se observa, los expertos humanos han tenido que leer los textos legales y representar partes relevantes de su contenido en una forma que los modelos computacionales podrían usar. ( Ashley, 2017, p. 5, 29)

En este sentido, Ashley propone una serie de preguntas intrigantes, relativas a la posibilidad de saber si las computadoras podrían razonar con la información legal extraída de los textos y ayudar a los usuarios, a plantear y probar hipótesis legales, presentar argumentos jurídicos o predecir los resultados de las disputas. La conclusión del autor es que “posiblemente sí”. Aunque queda una cantidad considerable de investigación por hacer antes de que las nuevas aplicaciones legales puedan demostrar todo su potencial ( Santosuosso y Pinotti, 2020).

Inteligencia artificial y heurística jurídica

En la línea de investigación abierta por las inquietudes de Ashley, se ubica una de las aplicaciones más novedosas de la inteligencia artificial en el mundo jurídico, es decir, su aplicación al tema de la heurística jurídica.

El término heurístico se refiere a una estrategia deliberada o no, que se basa en una evaluación natural para realizar una estimación o una predicción ( Kahneman y Tversky, 1983). En este caso, las personas no emplean ningún sistema normativo en sus estimaciones probabilísticas, en su lugar, se apoyan en un número limitado de heurísticos que simplifican la complejidad de las tareas y permiten una solución rápida ( Novo et ál., 2003, p. 7). Un heurístico, es una especie de directriz general que pueden seguir los seres humanos para tomar una decisión. Normalmente, una persona acostumbra a recordar la forma en que actuó en una situación análoga a la hora de decidir, determinando así un patrón de conducta frecuente y volviendo a actuar, en la situación concreta, del mismo modo. Se trata de una especie de cálculo estadístico bastante intuitivo. ( Nieva, 2018, p. 45)

Se colige, por tanto, que el comportamiento de los seres humanos, muchas veces, es previsible, toda vez que se actúa de manera automática. Igualmente, es normal que las personas se empeñen en hacer, de manera sistemática, una y otra vez la misma cosa, aunque su actuación sea errada. A esto último se le conoce como heurístico de anclaje y ajuste, el cual, además, tiene un impacto determinante en las actuaciones judiciales. El heurístico de anclaje y ajuste nos dice que:

[…]las personas, probablemente para simplificar la realidad, tienden a hacerse una idea desde un principio de la solución de un caso concreto. Si ello es así, lo siguiente que sucede es que luchar contra ese perjuicio es dificilísimo. Por muchas informaciones que reciba el sujeto en sentido contrario a su posicionamiento inicial, tenderá a reinterpretar esas informaciones en apoyo de su posición primigenia, manipulando o tergiversando esos datos. Es el error que se conoce con el nombre de sesgo de confirmación. ( Nieva, 2018, p. 50)

Ahora bien, los jueces, aunque se vistan con toga, siguen siendo humanos y, por ende, también desarrollan rutinas predecibles en muchas situaciones procesales. Esta situación se puede constatar cuando los administradores de justicia resuelven las causas de forma sistemática, con el fin de volver más simple y ágil su trabajo, es el caso, por ejemplo, de copiar consideraciones o argumentos en distintos casos similares o en el caso de los jueces que tienen excesiva carga laboral, “aumentan la mecanización de sus decisiones, volviéndose estas, decisiones rápidas pero superficiales” ( Nieva, 2018, p. 45). También sucede que “los seres humanos se dejan condicionar por variables emocionales introducidas por el lenguaje o la apariencia” ( Nieva, 2018, p. 52), aquí es donde aparece el heurístico denominado de afección y resulta relevante a la hora de que los jueces decidan imponer alguna medida cautelar basándose en la figura del periculum in mora en civil o libertatis en penal. En torno a lo anterior, se plantea que “es fácil afirmar que una persona con antecedentes puede reincidir, pero ¿es ello seguro? ¿Cómo podríamos saber si una persona con patrimonio suficiente va a eludir sus futuras obligaciones económicas en la insolvencia?”. Estas preguntas se terminan respondiendo en los estrados judiciales a través de una serie de “automatismos que pocas veces resisten la crítica” ( Nieva, 2018, p. 61). Todo esto, sirve para afirmar que posiblemente la actuación de los jueces dentro de los procesos judiciales, a pesar de estar sometidos a parámetros legales, es previsible.

Existen teorías del comportamiento judicial que se centran en la explicación de las decisiones judiciales. Esas teorías, que seguramente hoy resultan incompletas, son: “la actitudinal, la estratégica, la sociológica, la psicológica, la económica, la organizacional, la pragmática, la fenomenológica y la legalista” ( Posner, 2011, p. 31). Todas esas teorías, básicamente, tratan acerca del comportamiento judicial en función de la ideología o preferencias políticas de los jueces, a su estricto cumplimiento o apego de la ley, a las prevenciones existentes de sus decisiones frente a otros poderes públicos, a la búsqueda de una providencia más útil económicamente o a la aceptación de sus fallos socialmente.

En ese orden de ideas, se podría utilizar la inteligencia artificial (AI) en pro de la administración de justicia, partiendo de la heurística que existe por parte de los jueces en la toma de sus decisiones, así como también, en los procedimientos que se realizan en cada etapa procesal, en las cuales, la mayoría de las veces, ni siquiera es necesaria la intervención de un ser humano; por lo tanto, es viable diseñar un algoritmo que funcione en el mismo sentido, con la gran diferencia que este lograría una jurisdicción más célere y eficiente, garantizando de esta manera el acceso a la administración de justicia y una correcta impartición de esta.

A continuación, se relacionará una serie de posibilidades automatizables, en las cuales sería viable y necesaria la implementación de la IA en los procesos judiciales, desde el ejercicio del derecho de acción, hasta las etapas finales como la de la valoración probatoria, así:

-

Implementación de una plataforma donde se pueda directamente presentar una demanda y a su vez contestarla.

-

Posibilidad de que exista un mecanismo que revise y filtre inicialmente la demanda, con el fin de poder admitirla, inadmitirla o rechazarla.

-

Implementación de las llamadas online dispute resolution (ODR), o en español ‘resolución de disputas en línea’ (RDL). A través de este sistema se podrían resolver aquellos procesos en donde no existe ningún conflicto litigioso u oposición, como podría ser el caso de algunos de los procesos de jurisdicción voluntaria.

-

Utilización de la IA en los procesos ejecutivos, sobre todo porque se parte de un hecho u obligación cierta pero insatisfecha.

-

Decisión de excepciones previas, con el fin de sanear el proceso, sobre todo cuando las pruebas existentes son documentales.

-

Imposición de medidas cautelares. La IA ayudaría a estructurar de mejor manera y, sobre todo, a intentar objetivizar los riesgos y la búsqueda de los indicios en relación con el pericullum in mora, haciendo así, más previsible la orden de esta clase de medidas. De igual forma, ocurriría en el campo penal, ya se tiene el ejemplo del sistema COMPAS (Correctional Offender Management Profiling for Alternative Sanctions), el cual consiste en una herramienta que determina el riesgo de reincidencia en una persona. Es de anotar, y se ha demostrado, que este sistema de IA tiende a ser discriminatorio, pues sus algoritmos estaban programados para establecer altos índices de peligrosidad en afroamericanos, lo que no ocurría con los índices establecidos en personas de raza blanca.

-

La IA puede servir de soporte al juez en su función racional y crítica de valoración de la prueba. A la fecha, ya existen herramientas que ayudan al juez a ordenar sus razonamientos, realizando una construcción de los hechos a partir de situaciones ya existentes de casos anteriores. Es el caso, por ejemplo, de:

STEVIE (programa que construye historias coherentes partiendo de los datos existentes), o ECHO y PEIRCE-IGTT (aplicación que elabora hipótesis y estrategias de acusación y defensa), o el programa ALIBI, que ante un determinado delito hace un pronóstico de las diferentes explicaciones que pueda tener el comportamiento del reo. A su vez, está el programa Data Mining, cuyas herramientas recuperan los posibles escenarios del crimen basándose en escenas de crímenes anteriores, a los fines de prever dónde podrán hallarse indicios con mayor probabilidad. ( Nieva, 2018, p. 26)

-

Otro punto destacable tiene que ser la posibilidad de utilizar la IA como herramienta de apoyo en la función del juez de valoración de las pruebas periciales científicas. Es decir, se parte de la dificultad que se encuentra en el quehacer judicial de los administradores de justicia a la hora de valorar pruebas científicas allegadas al proceso, toda vez que, para ello, se requiere un cúmulo de conocimientos metajurídicos que, en la mayoría de los eventos, no existe. Además, la fiabilidad y confianza con que están revestidas las pruebas científicas, han conllevado a que exista una sobrevaloración de ellas, lo cual viene acompañado de un problema crucial: el que se alimente una actitud de veneración o de consideración. Existe, pues, una actitud deferencial de los jueces a las pruebas científicas, es decir, los jueces confían casi ciegamente en lo que dicen los expertos ( Luna, 2018, p. 125). En tal orden de ideas, con la utilización de la IA, se podría reducir los riesgos de una inadecuada valoración probatoria, suministrándole al juez elementos científicos de juicio que confirmen, refuten o encuentren anomalías en este medio de prueba o en el método científico empleado por el experto. Claro está que aquí también se podría incurrir por parte del juez en lo que se denomina sesgo de automatización, es decir, en la deferencia que se puede tener frente a las decisiones tomadas por una máquina y que afectarían, de igual forma, el debido proceso y la correcta impartición de administración de justicia.

-

Otro aspecto relevante y que en parte se identifica con el anterior, sobre todo en la ayuda que se puede obtener por parte de la IA, es en relación con la valoración de la prueba testimonial, especialmente en el marco de la Psicología del testimonio o Psicología Experimental. De acuerdo con estas ciencias, no existe un método fiable para descubrir cuando un testigo miente, así como tampoco es dable afirmar que siempre una persona miente conscientemente o de manera predispuesta o intencionada. Se ha concluido a partir de múltiples experimentos que una declaración testimonial nunca coincide o guarda relación fidedigna con lo acaecido en la realidad, es decir, existe una distorsión entre lo vivido o percibido, y lo expresado en el testimonio, situación que tiene su origen principalmente en el funcionamiento de nuestra memoria, por consiguiente, ninguno de los intervinientes dentro de un proceso, así como ningún miembro policial o experto en interrogatorios ni el mismo juez por más años de experiencia que tenga, tiene la capacidad de identificar ni interpretar la gestualidad subjetiva de cada testigo (Luna, 2021, p. 55). Así que, en este caso, la implementación de una herramienta de IA jugaría un papel crucial en la valoración de la credibilidad del testimonio, así como en la corroboración de la información suministrada por el testigo. A su vez, también sería relevante en la depuración y admisión de preguntas de un interrogatorio, buscando siempre, que estén acordes a las sugerencias y métodos que nos ofrece la psicología del testimonio, que, para estos casos, serían preguntas abiertas y que tiendan a que el declarante narre libremente su versión de la historia.

-

En cuanto a la prueba documental, se considera que es muy útil la IA para encontrar datos o filtrar información relevante, que, sin lugar a equívocos, contribuiría a que el juez realizara una mejor argumentación o motivación y, además, en un menor tiempo. Sin embargo, se ve con dificultad, la posibilidad de que esta herramienta de IA sirva o pueda interpretar o comprender situaciones específicas del documento, en donde necesariamente se requeriría la presencia del funcionario judicial.

-

En relación con la argumentación jurídica, sobre todo en las sentencias, la IA se convierta en una pieza clave de todo el engranaje judicial. Desde ya hace muchos años surgieron sistemas de asistencia jurídica que ayudan tanto en la argumentación como en el razonamiento jurisprudencial, como son QUESTMAP, ARGUMED, CATO, ROSS INTELLIGENCE o JURIMETRÍA.

-

En relación con el punto anterior, se puede, de igual forma, hacer referencia al sistema de IA de modelo de lenguaje denominado Chat GPT, por medio del cual el usuario puede interactuar de manera activa preguntando, consultando o pidiéndole al algoritmo lo que desee o necesite. En ese sentido, se puede encontrar un sistema y una herramienta de IA donde los jueces pudiesen argumentar o motivar sus decisiones a partir de las consultas realizadas a esta especie de chatbots.

-

De igual forma, se pudiese pensar o avizorar que la administración de justicia pudiese hacer uso en algunas circunstancias especiales de la IA y de experiencias inmersivas o multisensoriales como es el caso del Metaverso, donde se pasaría del mundo analógico al mundo digital a través de avatares. Por ejemplo, en la celebración de audiencias que tengan como finalidad esencial la protección de la integridad o intimidad de algún sujeto procesal, o para realizar entrevistas con menores de edad, o en su defecto para dinamizar y facilitar la actividad procesal en general.

Límites jurídicos al uso de la inteligencia artificial

Aunque la tecnología basada en la inteligencia artificial esté influenciando cada vez más la práctica jurídica, como se ha evidenciado en las páginas anteriores, cabe resaltar que se trata de una herramienta usada para evaluar y tomar decisiones que pueden impactar de manera directa y grave sobre la vida de las personas y, por ende, sobre sus derechos fundamentales y humanos. Por lo tanto, es imperativo encontrar un punto de equilibrio adecuado entre los beneficios que el desarrollo tecnológico brinda en términos de rapidez y automatismo de los procesos y la garantía de unos principios jurídicos irrenunciables y, particularmente, de los derechos fundamentales y humanos.

De hecho, la inteligencia artificial no puede concebirse como una Black Box, es trascendental que se puedan explicar los criterios de elaboración de los algoritmos; de esa manera se puede, en gran parte, garantizar una fiabilidad, una transparencia y la ausencia de cualquier sesgo en los datos. Todo esto, conllevaría a que existan herramientas de IA justas y transparentes. Es por ello por lo que Suárez y De León ( 2019) plantean que dentro de la aplicación de la inteligencia artificial al derecho resulta difícil la neutralidad axiológica o la liberación moral en la toma de decisiones, por cuanto si bien es cierto que los algoritmos no están inmersos en estas limitaciones conceptuales, sí están inmersas las personas que configuran los algoritmos (p. 80).

En tal sentido, Chakraborty ( 2018) aporta lo siguiente:

Machine learning in view of human conduct risks transmitting the mentioned inclinations in our general public to machines. This could mean, for instance, that AI utilized as part of prescient policing or advance endorsement frameworks would establish separation on the ground of race or sex—a conduct restricted by Article 14 of the Human Rights Convention. (p. 32)

Para esta finalidad, se han venido adoptando varias recomendaciones e incluso textos normativos, entre ellos, un punto particular lo presenta la normatividad adoptada en el marco del Consejo de Europa, es decir, la organización internacional en el marco de la cual se ubica el sistema del Convenio Europeo de los Derechos Humanos y su respectivo Tribunal. Por lo cual, se analizarán dos textos fundamentales que se han adoptado en ese contexto, los cuales constituyen un ejemplo y una guía para los Estados miembros de ese sistema, pero también ofrecen pautas interesantes en una perspectiva de análisis comparado.

La carta ética europea sobre el uso de la inteligencia artificial en los sistemas judiciales y su entorno

La Carta ética europea sobre el uso de la inteligencia artificial en los sistemas judiciales y su entorno, aprobada en diciembre de 2018, plantea cinco principios claves, que son:

- 1. Respeto por los derechos fundamentales: el cual consiste en que se debe garantizar que el diseño y la implementación de las herramientas y los servicios de inteligencia artificial sean compatibles con los derechos fundamentales. El procesamiento de las decisiones judiciales y los datos debe tener propósitos claros, en pleno cumplimiento de los derechos fundamentales garantizados por el Convenio Europeo de Derechos Humanos (CEDH) y el Convenio sobre la Protección de Datos Personales (Convenio para la Protección de las Personas con respecto al Procesamiento de datos personales, ETS No. 108 según lo enmendado por el protocolo de enmienda CETS No. 223). Cuando se utilizan herramientas de inteligencia artificial para resolver una disputa o como una herramienta para ayudar en la toma de decisiones judiciales o para brindar orientación al público, es esencial asegurarse de que no socaven las garantías del derecho de acceso al juez y el derecho a un juicio justo (igualdad de armas y respeto por el proceso de confrontación).

- 2. Principio de no discriminación: busca prevenir específicamente el desarrollo o intensificación de cualquier discriminación entre individuos o grupos de individuos. Dada la capacidad de estos métodos de procesamiento para revelar la discriminación existente, a través de la agrupación o clasificación de datosrelacionados con individuos o grupos de individuos, los interesados públicos y privados deben asegurarse de que los métodos no reproducen o agravan dicha discriminación y que no conducen a análisis o usos deterministas. Se debe tener especial cuidado en las fases de desarrollo e implementación, especialmente cuando el procesamiento es directo o indirectamente basado en datos sensibles. Esto podría incluir supuesto origen racial o étnico, antecedentes socioeconómicos, opiniones políticas, creencias religiosas o filosóficas, afiliación sindical, datos genéticos, datos biométricos, datos relacionados con la salud o datos relacionados con la vida sexual u orientación sexual. Cuando se haya identificado tal discriminación, se deben considerar medidas correctivas para limitar o, si es posible, neutralizar estos riesgos, así como la sensibilización entre las partes interesadas.

- 3.

Principio de calidad y seguridad: plantea que, con respecto al procesamiento de decisiones y datos judiciales, se deben utilizar fuentes certificadas y datos intangibles con modelos elaborados de manera multidisciplinaria, en un entorno tecnológico seguro. Los diseñadores de modelos de aprendizaje automático deberían poder aprovechar ampliamente la experiencia de los profesionales relevantes del sistema de justicia (jueces, fiscales, abogados, etc.) e investigadores/profesores en las áreas de derecho y ciencias sociales (economistas, sociólogos y filósofos).

Los datos basados en decisiones judiciales que se ingresan en un software que implementa un algoritmo de aprendizaje automático deben provenir de fuentes certificadas y no deben modificarse hasta que realmente hayan sido utilizados por el mecanismo de aprendizaje. Por lo tanto, todo el proceso debe ser rastreable para garantizar que no se haya producido ninguna modificación para alterar el contenido o el significado de la decisión que se está procesando.

- 4. Principio de transparencia, imparcialidad y justicia: este principio invita a hacer que los métodos de procesamiento de datos sean accesibles y comprensibles, y que se puedan autorizar auditorías externas. Se debe alcanzar un equilibrio entre la propiedad intelectual de ciertos métodos de procesamiento y la necesidad de transparencia (acceso al proceso de diseño), imparcialidad (ausencia de sesgo), justicia e integridad intelectual (priorizar los intereses de la justicia) cuando se utilizan herramientas que pueden tener consecuencias legales o afectar significativamente la vida de la gente.

- 5. Principio bajo control del usuario: se debe excluir un enfoque prescriptivo y garantizar que los usuarios sean actores informados y que controlen las elecciones realizadas con independencia judicial, en donde no se debe ni puede reemplazar al juez en sus razonamientos. Bajo este principio, la autonomía del usuario debe aumentarse y no restringirse mediante el uso de herramientas y servicios de inteligencia artificial. Los profesionales del sistema de justicia deberían, en cualquier momento, poder revisar las decisiones judiciales y los datos utilizados para producir un resultado y continuar sin estar obligados a ello a la luz de las características específicas de ese caso en particular. El usuario debe ser informado en un lenguaje claro y comprensible sobre si las soluciones ofrecidas por las herramientas de inteligencia artificial son vinculantes, sobre las diferentes opciones disponibles y si tiene derecho a asesoramiento legal y derecho a acceder a un tribunal. También debe estar claramente informado de cualquier procesamiento previo de un caso por inteligencia artificial antes o durante un proceso judicial y tener derecho a objetar. A su vez, cuando se implementa cualquier sistema de información basado en inteligencia artificial, debe haber programas de alfabetización informática para usuarios y debates en los que participen profesionales del sistema de justicia.

Unboxing artificial intelligence

En el mes de mayo de 2019, el Comisario de Derechos Humanos del Consejo de Europa adoptó un documento titulado “Unboxing artificial intelligence: 10 steps to protect human rights”, en el que se presentan diez recomendaciones con el objetivo de proporcionar orientación sobre la forma en la que se puede prevenir o mitigar el impacto negativo de los sistemas de inteligencia artificial en los derechos humanos ( Consejo de Europa, 2019, p. 6).

En la primera página de la introducción del texto se lee lo siguiente:

There is currently no agreed definition of ‘Artificial Intelligence’. However, for the purposes of this Recommendation, AI is used as an umbrella term to refer generally to a set of sciences, theories and techniques dedicated to improving the ability of machines to do things requiring intelligence. (Consejo de Europa, 2019, p. 1)

En otras palabras, el documento se abre con el reconocimiento de la dificultad de definir el objeto del estudio y es interesante notar cómo, aplicando un mecanismo típico del derecho, la solución presentada consiste en proponer una definición para los fines propios del texto normativo que se viene desarrollando (una definición, podríamos decir, artificial).

Las diez áreas clave identificadas por el documento son las siguientes:

-

6. Evaluación de impacto sobre los derechos humanos. Se recomienda que los Estados miembros establezcan un marco legal de procedimiento para que las autoridades públicas lleven a cabo evaluaciones de impacto sobre los derechos humanos (EIDH) en relación con los sistemas de inteligencia artificial adquiridos, desarrollados y/o implementados por esas autoridades.

-

7. Consultas públicas. El uso estatal de los sistemas de inteligencia artificial debe regirse por estándares de adquisiciones abiertos, aplicados en un proceso de ejecución transparente, en el que se invite a todas las partes interesadas pertinentes a aportar su opinión. Los Estados miembros deberían considerar actualizar sus normas relativas al acceso a la información, al gobierno transparente y a las políticas de contratación pública para reflejar los requisitos específicos de la inteligencia artificial, así como permitir la realización de consultas públicas en las distintas etapas de la interacción con un sistema de inteligencia artificial.

-

8. Obligación de facilitar la implementación de estándares de derechos humanos en el sector privado. Para cumplir con sus obligaciones positivas y de procedimiento en virtud del Convenio Europeo de Derechos Humanos, los Estados miembros deben aplicar las medidas que sean necesarias para proteger los derechos humanos de las personas contra las violaciones por parte de los actores privados a lo largo de todo el ciclo de vida de los sistemas de inteligencia artifical. Deben, además, aplicar medidas adicionales para exigir a los actores de la IA que respeten los derechos humanos, aplicando la debida diligencia en materia de derechos humanos.

-

9. Información y transparencia. El uso de un sistema de inteligencia artificial en cualquier proceso de toma de decisiones que tenga un impacto significativo en los derechos humanos de una persona debe ser identificable. El uso de un sistema de inteligencia artificial no solo debe hacerse público en términos claros y accesibles, las personas también deben poder comprender cómo se toman las decisiones y cómo se han verificado.

-

10. Supervisión independiente. Los Estados miembros deben establecer un marco legislativo para la supervisión independiente y eficaz del cumplimiento con la tutela de los derechos humanos en el marco del desarrollo, despliegue y uso de sistemas de inteligencia artificial por parte de las autoridades públicas y entidades privadas.

-

11. No discriminación e igualdad. En todas las circunstancias, los riesgos de discriminación deben prevenirse y mitigarse con especial atención a los grupos que tienen un mayor riesgo de que sus derechos se vean afectados de manera desproporcionada por la inteligencia artificial. Esto incluye mujeres, niños, personas mayores, personas económicamente desfavorecidas, miembros de la comunidad LGBTI, personas con discapacidades y grupos raciales, étnicos o religiosos.

-

12. Protección de datos y privacidad. El desarrollo, la formación, las pruebas y el uso de sistemas de inteligencia artificial que se basan en el procesamiento de datos personales deben garantizar plenamente el derecho de una persona al respeto de la vida privada y familiar en virtud del artículo 8 del Convenio Europeo de Derechos Humanos, incluido el “derecho a una forma de autodeterminación informativa” en relación con sus datos.

-

13. Libertad de expresión, libertad de reunión y asociación y derecho al trabajo. En el contexto de su responsabilidad de respetar, proteger y cumplir los derechos humanos y las libertades fundamentales de todas las personas, los Estados miembros deben tener en cuenta todo el espectro de normas internacionales de derechos humanos que puede implicar el uso de la inteligencia artificial, entre ellas, las que tutelan los derechos mencionados.

-

14. Remedios. Los sistemas de inteligencia artificial siempre deben permanecer bajo control humano, incluso en circunstancias en las que el aprendizaje automático o técnicas similares permitan que el sistema tome decisiones independientemente de una intervención humana específica. Los Estados miembros deben establecer parámetros claros de responsabilidad por las violaciones de derechos humanos que puedan surgir en varias fases del ciclo de vida de un sistema de inteligencia artificial

-

15. Promoción de la "alfabetización en IA". Se debe promover el conocimiento y la comprensión de la IA en las instituciones gubernamentales, los órganos de supervisión independientes, las estructuras nacionales de derechos humanos, la actividad judicial y ejecutiva, así como el público en general. Los Estados miembros deberían considerar la posibilidad de establecer un órgano consultivo dentro de sus estructuras gubernamentales para brindar asesoría sobre todos los asuntos relacionados con la IA.

Conclusiones

Se puede considerar que es una verdad de perogrullo la idea de que la IA llegó para cambiar nuestra vida de manera drástica en muchos aspectos, y siendo así, ha impactado también sobre el fenómeno del derecho y la práctica jurídica. En este sentido, es clave entender que la IA no puede considerarse como un fin en sí mismo, sino como un medio. Es importante, que el derecho se adapte a los cambios y a los avances científicos y tecnológicos que existen hoy en día, y que, en buena medida, puedan ser utilizados y empleados correctamente en beneficio de la correcta impartición y administración de justicia. Pero también es vital que el derecho no renuncie a la afirmación de sus principios básicos y que, a su vez, la IA esté acorde a los estándares de tutela de los derechos fundamentales y humanos.

Solo de esta forma será posible garantizar que el derecho no esté ciego a las novedades que se presentan en la realidad, pero, a la vez, no renuncie a la lógica que lo caracteriza, que es necesariamente una lógica de orientación normativa de la realidad misma. En este sentido, parece trascendental que todo estudio relacionado con los desafíos que los nuevos desarrollos de la ciencia y de la tecnología imponen a la juridicidad, no deberían olvidar que la aspiración y esencia de esta última no consiste solamente en adaptarse a ellos, sino también y, sobre todo, en tratar de orientarlos y ordenarlos conforme a unos valores y principios irrenunciables. Sin esta aspiración, se perdería la posibilidad misma de hablar de una cultura jurídica, la que se debe necesariamente entender como cultura del deber ser y de los derechos en clave garantista.

Referencias

Acosta, J. E. y Gual, J. M. (2021). La delimitación de la libertad contractual en virtud de exigencias sociales . Revista IUSTA, (55).

Aguirre-Espinosa, J. E. (2020). Reflexiones sobre el derecho y el juez algoritmo. Ratio Juris UNAULA, 15(30), 272–276.

Ashley, K. (2017). Artificial Intelligence and Legal Analytics: New Tools for Law Practice in the Digital Age. Cambridge University Press

Cairo, O. (2011). El hombre artificial. El futuro de la Tecnología. Editorial Alfaomega.

Chakraborty, S. (2018). Inteligencia artificial y derechos humanos: ¿son convergentes o paralelos entre sí?. Novum Jus, 12(2), 13-38. https://doi.org/10.14718/NovumJus.2018.12.2.2

Comisión Europea. (2018, 25 de abril). Communication-Artificial Intelligence for Europe. European Commission. https://digital-strategy.ec.europa.eu/en/library/communicationartificial-intelligence-europe

Consejo de Europa, Comisionado de Derechos Humanos. (2019). Unboxing artificial intelligence: 10 steps to protect human rights. https://rm.coe.int/unboxing-artificial-intelligence-10steps-to-protect-human-rights-reco/1680946e64

Galvis, L., y Pesca, D. A. (2020). Límites del tratamiento de los datos personales en el ámbito laboral frente al uso de las tecnologías de la información y comunicación en la era digital. IUSTA, (52), 51-76. https://doi.org/10.15332/25005286.5482

Galvis, L. y Salazar, R. (2018). Alcance del derecho al olvido en el tratamiento de datos personales en Colombia. Revista Verba Iuris, 14 (41), 45-63.

Gutiérrez, J. (2020). Retos Éticos de la Inteligencia Artificial en el Proceso Judicial. En XLI Congreso Colombiano De Derecho Procesal, Derecho Procesal. # Nuevas Tendencias (pp. 499-516). Instituto Colombiano de Derecho Procesal.

Hayek, A. (1973). Law, Legislation and Liberty. Routledge.

Ho, A. (2020). Inteligencia Artificial y Administración de Justicia. En XLI Congreso Colombiano De Derecho Procesal, Derecho Procesal. # Nuevas Tendencias (pp. 489-498). Instituto Colombiano de Derecho Procesal.

Kahneman, D. y Tversky, A. (1983). Extensional vs. intuitive reasoning: the conjunction fallacy in probability judgment. Psychological Review, 90 (4), 293-315. https://faculty.econ.ucdavis.edu/faculty/nehring/teaching/econ106/readings/Extensional%20Versus%20Intuitive.pdf

Luna, F. (2018). El mito del cientificismo en la valoración de la prueba científica. Jurídicas cuc, 14(1), 119-144

Luna, F. (2021). Fiabilidad de la prueba testimonial: breve análisis desde la psicología del testimonio y los errores de la memoria. Prolegómenos, 24(48), 53-67. https://doi.org/10.18359/prole.5701

Martínez, G. (2012). La inteligencia artificial y su aplicación al campo del Derecho. Alegatos Revista, (82), 827-846, http://alegatos.azc.uam.mx/index.php/ra/article/view/205 Nieva, J. (2018). Inteligencia Artificial y proceso judicial. Marcial Pons.

Nieva, J. (2018). Inteligencia Artificial y proceso judicial. Marcial Pons.

Novo, M., Arce, R., y Fariña, F. (2003). El heurístico: perspectiva histórica, concepto y tipología. En M. Novo y Arce, R. (Eds.), Jueces: Formación de juicios y sentencias (pp. 39-66). Granada: Grupo Editorial Universitario.

Pertuz, A. y Ropain, A. (2021). Desafíos contemporáneos a la relación problemática entre redes sociales y el ejercicio del derecho fundamental a la libertad de expresión Vis Iuris. Revista de Derecho y Ciencias Sociales,8(15)

Posner, R. (2011). Cómo deciden los jueces. Marcial Pons.

Russell, S. y Norving, P. (2004). Inteligencia Artificial: Un Enfoque Moderno (2ª. Edición). Prentice Hall. http://jdelagarza.fime.uanl.mx/IA/Libros/inteligencia-artificial-un-enfoquemoderno-stuart-j-russell.pdf

Santosuosso, A. y Pinotti, G. (2020). Bottleneck or Crossroad? Problems of Legal Sources Annotation and Some Theoretical Thoughts. Stats, 3(3), 376-395; https://doi.org/10.3390/stats3030024

Suárez, W. Y. y De León, G. I. (2019). Inteligencia artificial y su aplicación en la administración de justicia. Revista Jurídica Mario Alario D´Filippo, 11(21), 71–83.

Tierney, B. y Kelleher, J. (2018). Data Science. The MIT Press.

Vargas, A.M. (2018). Los límites y las consecuencias reales del discurso jurídico de la autonomía privada de la voluntad en el individuo . IUSTA, 2(49), 91-114.

Zabala, T. y Zuluaga, P (2021). Los retos jurídicos de la inteligencia artificial en el derecho en Colombia. Jurídicas CUC, 17(1). https://doi.org/10.17981/juridcuc.17.1.2021.17

Notes

Author notes